Powrót

Początki Informatyki: Od Abaka do Pierwszych Komputerów - Lekcja dla Maturzystów

Początki Informatyki: Od Abaka do Pierwszych Komputerów - Lekcja dla Maturzystów

Wprowadzenie do historii informatyki

Rozumienie historii informatyki jest nieodzowne dla maturzystów przygotowujących się do egzaminu z tego przedmiotu przy pomocy platformy MaturaMindsMaturaMinds. Historia informatyki nie tylko obrazuje, jak przebiegał rozwój narzędzi obliczeniowych od najprostszych mechanizmów po zaawansowane urządzenia, które znamy dziś, ale również pozwala zrozumieć podstawowe zasady działania współczesnych technologii. Znaczenie teorii informatyki jest równie ważne jak umiejętności praktyczne, gdyż pozwala na głębsze zrozumienie materiału oraz krytyczne myślenie niezbędne podczas rozwiązywania problemów informatycznych.

Pierwotne narzędzia do liczenia

Początki informatyki można prześledzić dzięki rozwojowi narzędzi do liczenia, które służyły ludzkości od zarania dziejów. Abak, znany również jako liczydło, jest jednym z najstarszych narzędzi do obliczeń i był używany przez starożytne cywilizacje, takie jak Sumeryjczycy czy Egipcjanie. Jego prostota polega na przesuwaniu koralików po drucikach lub rowkach, co umożliwiało wykonywanie podstawowych operacji matematycznych.

Innym prymitywnym narzędziem do liczenia był patyczek do liczenia używany przez różne kultury, umożliwiający zapisywanie liczb poprzez układanie patyczków lub kamieni w określonych wzorach.

Ważnym krokiem w ewolucji technologii obliczeniowych było wynalezienie maszyny analitycznej przez Charlesa Babbage'a w XIX wieku, która jest często uznawana za prototyp współczesnego komputera.

Zrozumienie tych narzędzi i ich znaczenie w historii informatyki pozwala docenić, jak daleko zaszliśmy od prostych mechanizmów do skomplikowanych systemów komputerowych, które teraz dominują świat. Rozwojowi narzędzi do liczenia towarzyszyła ewolucja myślenia matematycznego i informatycznego, co z kolei przyczyniło się do rozwoju algorytmów i języków programowania, stanowiących fundament dzisiejszej informatyki.

MaturaMinds oferuje kursy przygotowujące do egzaminu maturalnego z informatyki, skupiając się nie tylko na praktycznych umiejętnościach programowania, ale także na teoretycznym zrozumieniu ewolucji i znaczenia informatyki w historii ludzkości. To podejście pomaga uczniom nie tylko przygotować się do matury, ale również buduje solidne podstawy dla przyszłych studiów i kariery w dziedzinie technologii.

Ćwicząc z MaturaMinds uczniowie mają szansę nie tylko zapoznać się z historią i teorią informatyki, ale również z practical aspects - od algorytmów po programowanie w językach takich jak Python. Dzięki temu przygotowanie do matury staje się nie tylko skuteczne, ale i ciekawe, otwierając przed maturzystami drzwi do fascynującego świata informatyki.

Odkrycie algorytmów i ich ewolucja

Świat informatyki, który znamy dzisiaj, opiera się na fundamencie algorytmów. Jednakże, by zrozumieć, jak doszliśmy do obecnego stanu, musimy cofnąć się do czasów Al-Chwarizmi - perskiego matematyka, którego prace stanowią kamień milowy w rozwoju matematyki i informatyki. To właśnie od jego imienia pochodzi słowo "algorytm", co podkreśla jego niezaprzeczalny wkład w tę dziedzinę. Al-Chwarizmi w IX wieku opracował systematyczne metody rozwiązywania równań liniowych i kwadratowych, których zasady stosujemy do dzisiaj.

Jego prace wywarły ogromny wpływ na rozwój algorytmiki, będąc prekursorem dla wielu późniejszych odkryć. Przykładem ewolucji algorytmów, inspirowanych pracą Al-Chwarizmi, jest metoda sortowania bąbelkowego, prosta lecz skuteczna technika sortowania danych. Jest to przykład, jak podstawowe koncepcje z przeszłości ewoluują i znajdują zastosowanie w nowoczesnych technologiach.

# Przykład kodu Pythona ilustrującego sortowanie bąbelkowe

def bubbleSort(arr):

n = len(arr)

for i in range(n):

for j in range(0, n-i-1):

if arr[j] > arr[j+1] :

arr[j], arr[j+1] = arr[j+1], arr[j]

# Użycie funkcji sortowania bąbelkowego

arr = [64, 34, 25, 12, 22, 11, 90]

bubbleSort(arr)

print ("Posortowana tablica:")

for i in range(len(arr)):

print ("%d" %arr[i], end=" ")W tym przykładzie kodu widzimy, jak elegancko zaimplementować sortowanie bąbelkowe w Pythonie. Jest to doskonały przykład algorytmu, który, mając swoje korzenie w dawnych czasach, do dzisiaj znajduje zastosowanie w nowoczesnej informatyce.

Jak powstała pierwsza maszyna do liczenia?

Kolejnym kamieniem milowym w historii informatyki jest wynalazek Blaise’a Pascala, francuskiego matematyka i fizyka. W 1642 roku stworzył on pierwszą mechaniczną maszynę do liczenia, znaną jako Pascalina, umożliwiającą wykonywanie operacji dodawania i odejmowania. Projektując Pascalina, Pascal przedstawił światu koncepcję automatyzacji obliczeń, co wyznaczyło nową erę w rozwoju technologii.

Pascalina, mimo swojej prostoty, stanowiła fundament dla przyszłych badań i rozwoju maszyn liczących. Jej wpływ na rozwój technologii komputerowych jest niepodważalny, ponieważ ukazała możliwości i potencjał mechanizacji w przetwarzaniu informacji.

Ewolucja maszyn liczących

Ewolucja maszyn liczących z mechanicznych rozwiązań, takich jak Pascalina, do elektromechanicznych i wreszcie elektronicznych maszyn jest fascynująca. Kluczowym etapem w tej ewolucji stała się maszyna Enigma, wykorzystywana przez Niemcy podczas II wojny światowej do szyfrowania komunikacji. Enigma, choć miała za zadanie szyfrowanie wiadomości, znacznie przyczyniła się do rozwoju technologii obliczeniowych, zwłaszcza w kontekście projektowania systemów do deszyfrowania.

Przełomem stało się jednak odkrycie, że maszyny takie jak Enigma mogą być pokonane przez odpowiednio zaprojektowane algorytmy i maszyny do ich przetwarzania, co z kolei przyspieszyło rozwój elektronicznych maszyn obliczeniowych. Rola szyfrowania i deszyfrowania w historii informatyki jest więc podwójna - z jednej strony stanowiła potężną motywację do rozwijania nowych technologii, z drugiej zapoczątkowała erę komputeryzacji i cyfryzacji danych.

Wszystkie te etapy, począwszy od matematycznych teorii Al-Chwarizmi, poprzez wynalazek Pascala, a na ewolucji maszyn liczących kończąc, są żywym dowodem na to, jak informatyka rozwijała się przez wieki. Dla studentów korzystających z platformy MaturaMindsMaturaMinds, zrozumienie tych podstawowych koncepcji i historii jest nie tylko fascynującą podróżą przez czas ale także solidnym fundamentem dla dalszej nauki i eksploracji świata informatyki.

Czym był ENIAC?

ENIAC, czyli Electronic Numerical Integrator and Computer, był pierwszym dużym komputerem elektronicznym zdolnym do programowania na potrzeby rozwiązania dużej klasy problemów matematycznych. Zaprojektowany i zbudowany w latach 40. XX wieku przez Johna W. Mauchly'ego i J. Prespera Eckerta na Uniwersytecie Pensylwanii, ENIAC zmienił sposób myślenia o komputerach i informatyce.

Konstrukcja ENIAC-a wykorzystywała około 18 000 lamp elektronowych, ważyła około 30 ton i zajmowała powierzchnię ponad 167 metrów kwadratowych. Mimo swoich imponujących rozmiarów i skomplikowanej budowy, ENIAC był w stanie realizować obliczenia tysiące razy szybciej niż jakiekolwiek inne dostępne wówczas urządzenia. Pierwotnie stworzony do celów wojskowych, szybko znalazł zastosowanie w różnych dziedzinach nauki i inżynierii. Jego wpływ na przyszłe konstrukcje komputerów był ogromny, stanowiąc przełom w rozwoju technologii cyfrowej i przyczyniając się do powstania nowoczesnej informatyki.

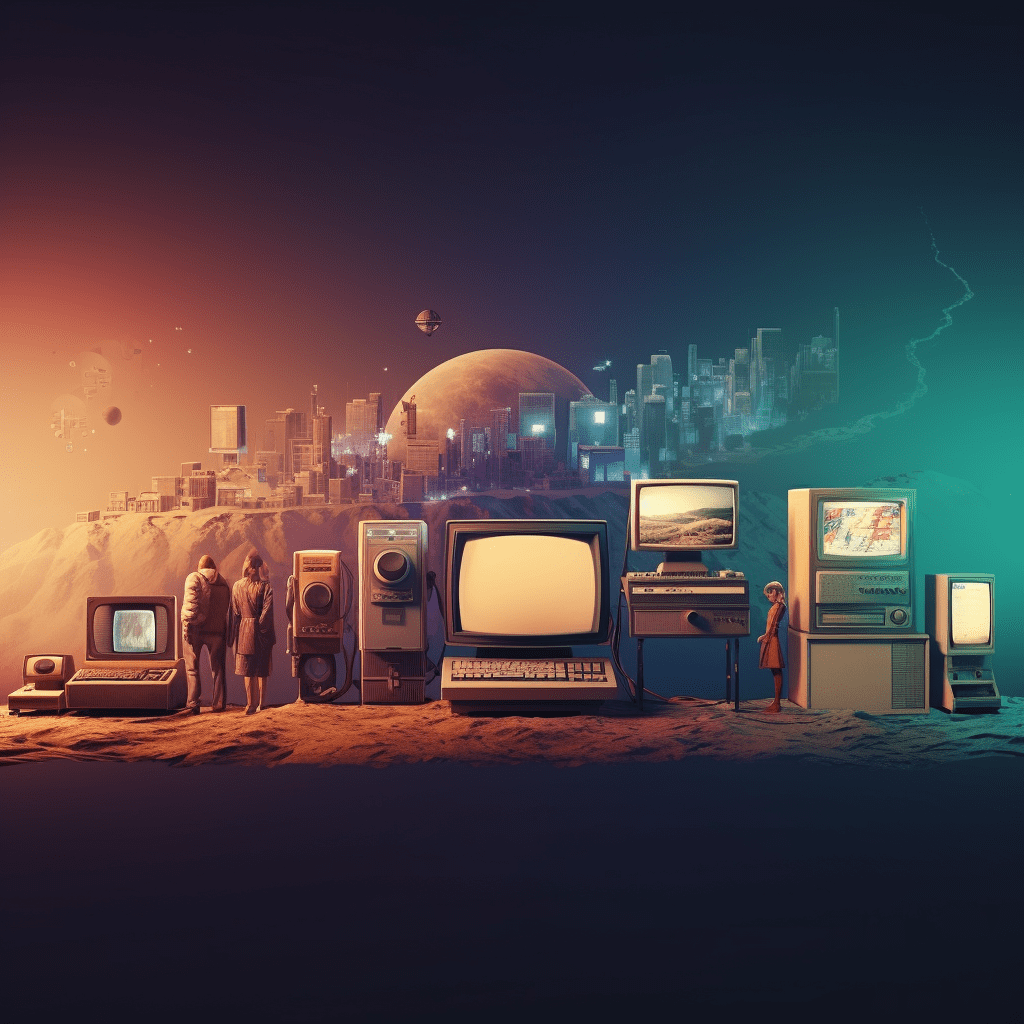

Jak rozwijała się informatyka po wynalezieniu ENIAC-a?

Po stworzeniu ENIAC-a, rozwój technologii komputerowych przyspieszył. Począwszy od wprowadzenia tranzystorów, które zastąpiły lampy elektronowe, przez rozwój pierwszych układów scalonych, po wynalezienie mikroprocesora - te kroki milowe umożliwiły tworzenie mniejszych, szybszych i bardziej niezawodnych maszyn.

W latach 70. świat ujrzał pojawienie się pierwszych komputerów osobistych (PC), które umożliwiły szerokiej publiczności dostęp do technologii komputerowej. Maszyny takie jak Apple II, Commodore 64 czy ZX Spectrum stały się symbolem tej nowej ery. Dziś, dzięki rozwojowi informatyki, dysponujemy technologią, która kiedyś wydawała się science-fiction: od potężnych laptopów, przez smartfony, aż po cloud computing i sztuczną inteligencję.

Jakie były kluczowe momenty w historii informatyki?

W historii informatyki było wiele kluczowych momentów, które znacząco wpłynęły na jej rozwój. Niektóre z najważniejszych wydarzeń to:

- Wynalezienie mikroprocesora w 1971 roku. Revolutionizing the design and manufacture of computers, mikroprocesory umożliwiły miniaturyzację maszyn i były kluczowym elementem umożliwiającym pojawienie się komputerów osobistych.

- Powstanie Internetu. Początkowo zbudowany w celach wojskowych i akademickich, Internet został udostępniony publiczności na początku lat 90. Jego rozwój zrewolucjonizował sposób, w jaki komunikujemy się, pracujemy i bawimy.

- Wprowadzenie komputerów osobistych w latach 70. i 80. Umożliwiły one masowej publiczności dostęp do technologii komputerowej, zmieniając sposób życia, pracy i edukacji milionów ludzi na całym świecie.

W kontekście kursu z informatyki oferowanego przez MaturaMindsMaturaMinds, zrozumienie tych momentów i roli, jaką odgrywały w kształtowaniu dzisiejszej informatyki, jest niezbędne dla każdego maturzysty. Gdy rozważasz ogromny wpływ, jaki te wynalazki miały na rozwój społeczeństwa informacyjnego, warto zauważyć, jak każdy z tych kluczowych momentów przyczynił się do przekształcenia świata, jaki znamy.

Rola informatyki w dzisiejszym świecie

Współczesny świat jest niemal nie do poznania bez uwzględnienia wpływu, jaki informatyka wywarła na każdy aspekt naszego życia. Od komunikacji międzyludzkiej, przez sposób, w jaki prowadzimy biznes, aż po zarządzanie globalną gospodarką, informatyka stanowi trzon współczesnych społeczeństw. Komunikacja, która kiedyś wymagała dni na dostarczenie listu, teraz dzieje się w czasie rzeczywistym dzięki e-mailom, komunikatorom i mediom społecznościowym. Biznesy wykorzystują oprogramowanie do zarządzania zasobami, logistyką i analizą danych, co pozwala na efektywniejsze decyzje strategiczne. W gospodarce, transakcje finansowe przetwarzane są w sekundy, a informatyka pozwala na analizę dużych zbiorów danych w celu przewidywania trendów rynkowych.

Zrozumienie, jak informatyka wpływa na te obszary, jest kluczowe nie tylko dla osób związanych z branżą IT. Każdy maturzysta przygotowujący się do przyszłych studiów lub kariery zawodowej powinien zdawać sobie sprawę z roli, jaką informatyka odgrywa w dzisiejszym świecie. Odpowiednia wiedza i umiejętności informatyczne mogą być decydujące w osiągnięciu sukcesu na współczesnym rynku pracy.

Jak zrozumieć początki informatyki może pomóc w przygotowaniach do matury

Rozumienie początków informatyki i jej ewolucji przez wieki ma fundamentalne znaczenie dla każdego maturzysty, który wybiera kurs Informatyka na MaturaMindsInformatyka na MaturaMinds. Historia informatyki, pełna przełomów technologicznych oraz geniuszy, którzy przesuwali granice możliwości obliczeniowych, stanowi podstawę do lepszego zrozumienia obecnych technologii. Być może pojawiające się na maturze pytania dotyczyć będą właśnie tych fundamentów, które zdecydowały o dzisiejszym obliczu informatyki.

Dla przykładu, pytanie examinacyjne może dotyczyć przewagi maszyn cyfrowych nad analogowymi czy wyjaśnienia, jak pierwsze algorytmy i języki programowania wpłynęły na rozwój oprogramowania. Wiedza na temat pierwszych komputerów, takich jak ENIAC czy maszyna Turinga, nie tylko poszerza horyzonty, ale też pozwala lepiej zrozumieć dzisiejsze systemy komputerowe.

Jak powstała pierwsza programowalna maszyna do liczenia?

Pierwsza programowalna maszyna do liczenia to dzieło Charlesa Babbage'a – Difference Engine i analityczna maszyna. Babbage, matematyk i wynalazca epoki wiktoriańskiej, zaprojektował Difference Engine w 1822 roku jako urządzenie mechaniczne zdolne do obliczeń. Jednak to jego późniejsza praca nad Analityczną Maszyną zapoczątkowała era komputerów programowalnych. Maszyna ta, choć nigdy nie została w pełni zbudowana za życia Babbage’a, zaprojektowana została do interpretowania programów zapisanych na kartach perforowanych, umożliwiając realizację różnych zadań obliczeniowych. Miała być uniwersalną maszyną obliczeniową, co ją śmiało przekształca w prototyp współczesnych komputerów.

Dzieło Babbage'a i jego wizja programowalnych maszyn jest fundamentalnym kamieniem milowym w historii informatyki. Podstawy programowania, choć w formie znacznie różniącej się od dzisiejszych, kładzione były już w XIX wieku. Zrozumienie, jak znaczący krok technologiczny został wykonany przez Babbage’a, pozwala docenić trud, innowacyjność i geniusz ludzi, którzy legli u podstaw współczesnych technologii informatycznych.

Analizując rozwój informatyki od pierwszych mechanizmów po zaawansowane systemy cyfrowe, maturzyści na platformie MaturaMinds zdobywają nie tylko teoretyczną wiedzę. Przygotowują się do zrozumienia dynamicznego świata technologii, w którym zmiany są jedyną stałą. Ta wiedza i zdolność adaptacji do na bieżąco zmieniającego się środowiska IT są kluczowe dla każdego, kto myśli o karierze w dziedzinie informatyki.

Dlaczego wynalezienie mikroprocesora było kluczowe dla rozwoju komputerów?

Wciąż zachwycając się nowoczesnymi technologiami, często zapominamy o kamieniach milowych, które umożliwiły ich rozwój. Jednym z takich przełomów, stanowiącym niewątpliwie fundament rozwoju nowoczesnej informatyki, było wynalezienie mikroprocesora. Mikroprocesor, często nazywany "mózgiem" komputera, jest zintegrowanym obwodem elektronicznym, który wykonuje instrukcje zapisane w pamięci komputera, aby przetwarzać dane. Co czyni go tak istotnym?

Rozwój mikroprocesora wpłynął nie tylko na miniaturyzację urządzeń elektronicznych, ale przede wszystkim znacząco zwiększył ich moc obliczeniową przy jednoczesnym obniżeniu kosztów produkcji. Dzięki temu, komputery, które kiedyś zajmowały całe pomieszczenia, mogły zostać zmniejszone do rozmiarów przenośnych urządzeń, takich jak laptopy czy smartfony.

Początkowo, w latach 50. i 60. XX wieku, komputery były budowane na bazie lamp elektronowych i tranzystorów. Były one wielkie, drogie w utrzymaniu i skomplikowane w obsłudze. Intel 4004, zaprezentowany w 1971 roku, był pierwszym na świecie komercyjnie dostępnym mikroprocesorem i stanowił początek ery mikrokomputerów. Ta rewolucyjna zmiana pozwoliła na znacznie szersze zastosowanie komputerów, przenosząc je z laboratoriów badawczych bezpośrednio do użytku domowego i biznesowego.

Kluczowe zalety mikroprocesora to:

- Miniaturyzacja: Wprowadzenie mikroprocesora umożliwiło zmniejszenie rozmiarów urządzeń, co z kolei otworzyło drogę do tworzenia przenośnych komputerów i innych inteligentnych urządzeń.

- Efektywność energetyczna: W porównaniu z wcześniejszymi technologiami, mikroprocesory zużywają znacznie mniej energii, co jest kluczowe dla przenośnych urządzeń.

- Moc obliczeniowa: Zwiększenie mocy obliczeniowej przy jednoczesnym zmniejszeniu kosztów produkcji pozwoliło na dostępność komputerów dla szerszej grupy odbiorców.

- Wszechstronność: Mikroprocesory znalazły zastosowanie nie tylko w komputerach, ale również w wielu innych urządzeniach, takich jak telefony komórkowe, urządzenia noszone, a nawet samochody.

W dobie, gdy informatyka odgrywa kluczową rolę w niemal każdej dziedzinie życia, zrozumienie jej podstaw, w tym roli mikroprocesora, jest nie tylko fascynujące, ale również niezwykle użyteczne.

Podsumowanie i zaproszenie do dalszego odkrywania

Odkrywając początki informatyki i prześledziwszy drogę od pierwszych komputerów do mikroprocesorów, zdobywamy nie tylko wiedzę o historii technologii, ale również lepsze zrozumienie obecnych i przyszłych innowacji. Wynalezienie mikroprocesora było bez wątpienia jednym z kluczowych momentów, który zrewolucjonizował świat informatyki, umożliwiając rozwój nowoczesnych technologii, z których korzystamy na co dzień.

Zachęcam wszystkich maturzystów do pogłębiania swojej wiedzy nie tylko z zakresu informatyki, ale i innych przedmiotów. Wiedza ta nie tylko pomoże wam lepiej przygotować się do matury, ale również zainspirować do dalszej nauki i rozwoju. Dlatego też, zapraszam do odwiedzenia blogu MaturaMindsblogu MaturaMinds, gdzie znajdziecie wiele interesujących artykułów, które pomogą wam zrozumieć skomplikowane zagadnienia i łatwiej przyswoić wiedzę na egzamin maturalny.

Pamiętajcie, że zrozumienie historii informatyki, od abaka do mikroprocesorów, jest nie tylko ciekawe, ale również może być kluczem do waszego sukcesu na maturze i w przyszłych studiach oraz karierze. MaturaMinds jest tu, aby wspierać was w tej podróży, oferując kursy i materiały dostosowane do aktualnych wymagań maturalnych.

Czy podoba Ci się ten artykuł?

Zostaw nam swoją opinię

Powrót do bloga

Rozwiń wiedzę z tego artykułu dzięki MaturaMinds

Zainteresował Cię temat naszego artykułu? Wybierz kursy poniżej, któresą bezpośrednio powiązane z omawianą tematyką, aby dogłębnie przygotować się do egzaminu maturalnego. Każdy z nich został zaprojektowany z wymaganiami CKE na uwadze, aby skupić się na nauce, a nie na szukaniu materiałów.